L’opérateur télécoms a testé l’IA générative pour produire des résumés des conversations entre ses clients et ses conseillers. Une expérimentation concluante. Le passage en production auprès de l’ensemble de ses équipes chargées de la relation client est proche. Une très instructive plongée dans ce projet d’IA générative pour la relation client. (Photo Bouygues Telecom DR)

La technologie suscitait encore des doutes, mais les tests effectués avec IBM, partenaire de Bouygues Telecom depuis 5 ans dans la mise en oeuvre d’un programme d’acculturation à l’IA, ont suffi à les lever. Chez l’opérateur télécoms, l’IA générative, basée sur les grands modèles de langage (ou LLM pour Large Language Models), est appelée à s’intégrer dans les processus de la relation client. En commençant par répondre à un besoin que la technologie ne parvenait pas à couvrir jusqu’à présent : tirer parti des millions d’échanges enregistrés entre les conseillers de l’opérateur et ses clients pour améliorer les futurs contacts avec ces derniers. « Une des grandes questions concernant l’évolution de la relation client réside dans la capacité à capitaliser sur les conversations passées avec les clients, a pointé Simon Giraudy, directeur de la stratégie, des outils et de l’innovation dans la relation clients, à l’occasion de l’AWS Summit de Paris, le 4 avril 2022. Jusqu’alors, nous n’avions jamais trouvé les bons outils pour résumer efficacement des conversations d’une durée moyenne d’une dizaine de minutes. Dernièrement, nous avons senti que c’était le moment de réétudier la question. »

D’où le lancement d’une expérimentation pour tester le potentiel de l’IA générative sur ce cas d’usage précis. « Nous avons d’abord travaillé sur l’amélioration de la transcription des conversations en speech-to-text, détaille Selsabil Gaied, architecte data et IA chez IBM France. Puis nous avons évalué la pertinence de différents LLM dans la production de résumés en 5 points clefs avec un minimum de préparation de données. » Un galop d’essai qui fournit rapidement de premiers résultats encourageants, grâce au grand nombre de paramètres des réseaux de neurones des LLM couplés aux centaines de Go de données analysées. Et ce, malgré les complexités présentes dans les transcriptions (où les propos du conseiller ne sont, par exemple, pas séparés de ceux du client).

Réentraîner un modèle : quelques milliers d’euros

Cette première étape est ensuite complétée par une phase d’optimisation, afin d’ajuster les modèles au besoin spécifique de l’opérateur. Via notamment un travail sur la formulation de la bonne instruction (le prompt, dans le jargon des IA génératives). « Pour certains modèles, les résultats s’améliorent quand on spécifie le contexte. Pour d’autres, quand on apporte des exemples », illustre Selsabil Gaied. L’étape d’après ? Réentraîner les modèles – par essence généralistes – avec les données spécifiques à l’entreprise.

Simon Giraudy, directeur de la stratégie, des outils et de l’innovation dans la relation client de Bouygues Telecom : « Jusqu’alors, nous n’avions jamais trouvé les bons outils pour résumer efficacement des conversations durant en moyenne une dizaine de minutes. »

Pour mener à bien son expérimentation, IBM s’est reposé sur la plateforme d’apprentissage SageMaker d’AWS, afin « d’accélérer le processus, déployer rapidement les modèles, les tester et héberger le référentiel de prompts », comme l’indique l’architecte d’IBM. Par ailleurs, cette option permet d’industrialiser rapidement une solution, au besoin en la transformant en API. « Le choix du cloud permet aussi d’avoir accès aux bonnes ressources de calcul et de les payer à l’usage », reprend Selsabil Gaied.

Efficacité avérée, coûts maîtrisés. Autant d’arguments qui ont convaincu Bouygues Telecom d’aller plus loin. « Nous sommes convaincus que nous allons aller en production très vite. Faire ingérer des millions de conversations à un modèle LLM ne coûte aujourd’hui que quelques milliers d’euros. Or, les enjeux sont énormes : ce type d’applications peut éviter à un client de répéter plusieurs fois ses problématiques », indique Simon Giraudy.

Aller vite en production

Reste à trouver le bon modèle pour industrialiser ce qui reste une expérimentation à ce jour. Pour Matthieu Dupuis, responsable de l’IA au sein de la DSI de Bouygues Telecomsssssssd, quatre voies se présentent pour passer en production : « les API publiques, peu chères, mais qui soulèvent des questions en matière de maîtrise des données, de gestion des SLA ou d’optimisations fines adaptées à nos besoins ; les API managées, plus chères, mais qui permettent de bénéficier d’infrastructures réservées, de SLA encadrés et de capacités d’optimisation ; l’hébergement du modèle sur notre propre cloud, ce qui suppose de maîtriser l’infrastructure et supporter le coût de l’entraînement d’un modèle renfermant des dizaines de milliards de paramètres ; et, enfin, l’entraînement de nos propres modèles, une option pour laquelle nous ne sommes actuellement pas prêts. » Autrement dit, le choix de l’option la plus adéquate dépend d’un équilibre à trouver entre complexité technologique, coûts de mise en oeuvre et souveraineté de la donnée. Sans oublier la notion de time-to-market. « Notre volonté actuelle est d’aller vite, reprend Matthieu Dupuis. Donc peut-être de démarrer en mode SaaS avant d’optimiser les modèles par nous-mêmes dans une seconde phase. »

Matthieu Dupuis, responsable de l’IA au sein de la DSI de Bouygues Telecom : « Notre volonté actuelle est d’aller vite. Donc peut-être de démarrer en mode SaaS avant d’optimiser les modèles par nous-mêmes dans une seconde phase. »

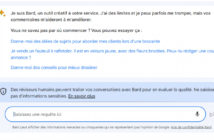

Pour le responsable IA de l’opérateur, ce déploiement des LLM n’est toutefois pas une remise en cause des principes fondamentaux de la stratégie déployée jusqu’alors. Ce qui soulève au moins deux points de vigilance. D’abord, la capacité à conserver une approche best-of-breed. « Aujourd’hui, une quinzaine de modèles sont éligibles pour réaliser des résumés des conversations entre conseillers et clients, observe Matthieu Dupuis. Nous voulons conserver la capacité à changer de modèle et à suivre l’évolution de ces technologies pour être en mesure de proposer, demain, un meilleur niveau de maîtrise du discours généré pour l’outil que nous proposons. » Le second point d’attention souligné par les équipes de Bouygues Telecom est directement corrélé à cette évolution, l’opérateur souhaitant, en effet, se prémunir de tout impact sur les clients. « C’est pourquoi nos scénarios de déploiement actuels ne ciblent que les utilisateurs internes, reprend Matthieu Dupuis. Vis-à-vis de nos clients, nous ne pouvons pas nous permettre les imperfections encore présentes dans les réponses des IA génératives. »

« L’impact sur les opérations ? Il reste des inconnues »

Mais, même limités aux conseillers clientèle de l’opérateur, l’arrivée de l’IA générative en production pourrait générer des effets de bord encore difficiles à anticiper. « La pertinence des résumés que l’IA générative est à même de proposer est assez incroyable par rapport à ce que nous connaissions auparavant, relève Selsabil Gaied. D’où la volonté d’avancer vite sur ce terrain, mais en gardant la tête froide. Car l’impact que va avoir la technologie sur les opérations comporte des inconnues. » Comme la production d’hallucinations, autrement dit d’éléments ‘inventés’ par les LLM. Ou encore, comme la manière dont des milliers de conseillers vont accueillir et exploiter ces résumés. « N’y verront-ils pas parole d’évangile ?, s’interroge la consultante. Même si les résumés produits sont brillants, nous avons besoin de mieux comprendre les effets qu’ils vont induire. » Pour ce faire, après avoir fait évaluer les résumés issus de l’expérimentation par des équipes de conseillers, Bouygues Telecom va donc passer à la phase d’industrialisation. Via des résumés de l’historique des conversations directement proposés dans Salesforce.